728x90

반응형

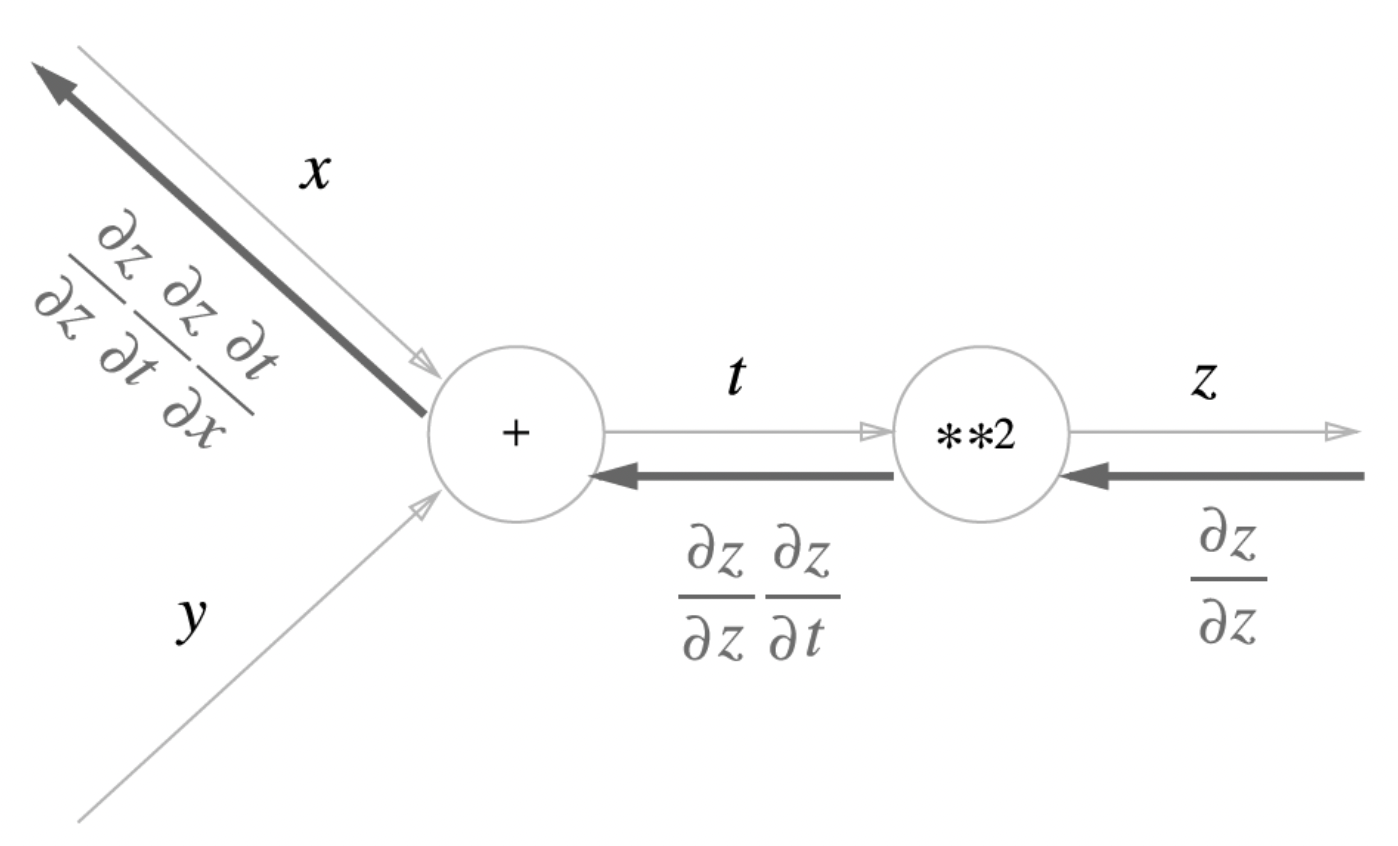

Chain Rule

z = t^2, t = x + y라 하면

계산 그래프로 나타내면 다음과 같다.

덧셈노드 역전파

상류의 값이 그대로 하류로 간다.

곱셈노드 역전파

상류의 값에 순전파 때의 입력 신호들을 서로 바꾼 값을 곱해서 하류로 간다.

Affine Layer

- 계산(행렬의 곱과 편항의 합)하는 계층

차원을 맞추기 위해 transpose 할 수도 있다.

배치용 Affine 계층

- 데이터를 N개 묶어 순전파 하는 경우에 대한 배치(Batch)용 Affine

사진 출처

https://mathsathome.com/chain-rule-differentiation/

728x90

반응형

'딥러닝' 카테고리의 다른 글

| 밑바닥부터 시작하는 딥러닝 Chapter6 - 가중치의 초깃값 (0) | 2022.06.26 |

|---|---|

| 밑바닥부터 시작하는 딥러닝 Chapter6 - 학습 관련 기술들 (0) | 2022.06.26 |

| 밑바닥부터 시작하는 딥러닝 Chapter4 - 신경망 학습 (0) | 2022.06.17 |

| 밑바닥부터 시작하는 딥러닝 Chapter3 - 신경망 (0) | 2022.06.14 |

| 밑바닥부터 시작하는 딥러닝 Chapter2 - Perceptron(퍼셉트론) (0) | 2022.06.13 |

댓글